Çindən süni intellekt sahəsində sensasion YENİLİK

Çinin süni intellekt sahəsində fəaliyyət göstərən startapı DeepSeek, sensasion bir açıqlama edərək, aparıcı süni intellekt şirkətlərinin modellərinə bənzər bir modeli 11 dəfə daha az hesablama gücü ilə hazırladıqlarını elan edib.

Çinin süni intellekt sahəsində fəaliyyət göstərən startapı DeepSeek, sensasion bir açıqlama edərək, aparıcı süni intellekt şirkətlərinin modellərinə bənzər bir modeli 11 dəfə daha az hesablama gücü ilə hazırladıqlarını elan edib.

Lent.az xəbər verir ki, DeepSeek-in təqdim etdiyi məlumatlara görə, OpenAI, Meta və Anthropic kimi nəhənglərin modellərinə bənzər DeepSeek-V3 adlı dil modeli cəmi 2 ay ərzində 2.048 Nvidia H800 GPU-sundan ibarət bir qrup vasitəsilə 671 milyard parametr üzərində öyrədilib. Bu, təxminən 2.8 milyon GPU saatı deməkdir. Müqayisə üçün, Meta-nın 405 milyard parametrə malik Llama 3 modelini 54 gün ərzində 16.384 H100 GPU istifadə edərək öyrətməsi üçün 11 dəfə daha çox hesablama gücü (30.8 milyon GPU saatı) tələb olunub.

DeepSeek, qabaqcıl əlaqə xətti (pipeline) alqoritmləri, optimallaşdırılmış rabitə çərçivəsi və FP8 aşağı dəqiqlikli hesablama üsulundan istifadə edərək bu cür miqyaslı modellər üçün adətən tələb olunan hesablama və yaddaş ehtiyaclarını əhəmiyyətli dərəcədə azaltdığını iddia edir. Şirkət, DeepSeek-V3 modelinin hesablama tələblərini azaltmaq üçün onlarla optimizasiya texnikası tətbiq etdiyini vurğulasa da, bir neçə əsas texnologiya bu nəticələrin əldə olunmasında həlledici rol oynayıb. DeepSeek, DualPipe adlı alqoritmdən istifadə edərək həm hesablama, həm də rabitə mərhələlərində effektivliyi artırdığını bildirir. Bu alqoritm, xüsusilə MoE arxitekturasının tələb etdiyi qovşaqlararası ekspert paralelliyi üçün təlim darboğazlarını minimuma endirib. Beləliklə, sıfıra yaxın rabitə yükü ilə 14.8 trilyon simvolun işlənməsi mümkün olub.

Bundan əlavə, DeepSeek rabitə zamanı istifadə olunan qovşaqların sayını hər simvol üçün maksimum 4 qovşaqla məhdudlaşdırıb. Bu yanaşma trafiki azaldıb və rabitənin hesablama ilə effektiv şəkildə üst-üstə düşməsinə imkan verib. Performans baxımından, şirkət DeepSeek-V3 MoE modelinin bəzi göstəricilər üzrə GPT-4x, Claude-3.5-Sonnet və LLama-3.1 modelləri ilə müqayisə edilə bilən, bəzən isə onları ötüb, keçən nəticələr verdiyini bildirir. Lakin bu iddiaların müstəqil tədqiqatçılar tərəfindən təsdiqlənməsinə ehtiyac var. Şirkət modeli və onun parametrlərini açıq mənbə kimi təqdim edib, buna görə də yaxın vaxtlarda müqayisəli testlərin aparılması gözlənilir.

DeepSeek-V3 modeli parametrlərin sayı və ya məntiqi düşünmə qabiliyyətləri baxımından GPT-4 və ya Llama-3 kimi qabaqcıl modellərdən geri qalsa da, məhdud resurslarla yüksək səviyyəli bir MoE modelinin hazırlanmasının mümkün olduğunu nümayiş etdirir. Təbii ki, bu, çoxlu optimizasiya və aşağı səviyyəli proqramlaşdırma tələb edir, lakin nəticələr olduqca ümidverici görünür. DeepSeek komandası, DeepSeek-V3 modelinin tətbiqinin inkişaf etmiş avadanlıqla yanaşı, prefilling və dekodlaşdırma mərhələlərini bir-birindən ayıran xüsusi paylama strategiyası tələb etdiyini, bunun isə resurs çatışmazlığı səbəbindən kiçik şirkətlər üçün əlçatmaz ola biləcəyini etiraf edir.

Sonxeber.az

Telegramda izləyin

Telegramda izləyin

Şikayətiniz varsa Whatsapp: 077 7125666

Facebookda Paylaş

İnsidentin baş verdiyi "İdrak"da astronomik təhsil haqları

İnsidentin baş verdiyi "İdrak"da astronomik təhsil haqları General-leytenant təqaüdə göndərildi

General-leytenant təqaüdə göndərildi Bakıda bu tarixlərdə GÜCLÜ KÜLƏK ƏSƏCƏK - XƏBƏRDARLIQ

Bakıda bu tarixlərdə GÜCLÜ KÜLƏK ƏSƏCƏK - XƏBƏRDARLIQ Deputatdan pensiyalarla bağlı ŞAD XƏBƏR

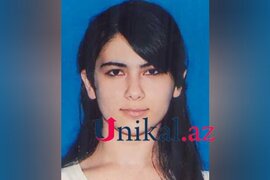

Deputatdan pensiyalarla bağlı ŞAD XƏBƏR "İdrak" liseyində güllələnən müəllimin FOTOSU

"İdrak" liseyində güllələnən müəllimin FOTOSU Azərbaycanda iki idarə ləğv olundu

Azərbaycanda iki idarə ləğv olundu "İdrak" liseyində güllələnən müəllimənin vəziyyəti - Açıqlandı

"İdrak" liseyində güllələnən müəllimənin vəziyyəti - Açıqlandı Bu tarixdə QISA İŞ GÜNÜ OLACAQ

Bu tarixdə QISA İŞ GÜNÜ OLACAQ Həmin şagird liseyə belə daxil olub - Video

Həmin şagird liseyə belə daxil olub - Video Müəllimini vurandan sonra BU CÜMLƏNİ İŞLƏDİB - YENİ DETAL

Müəllimini vurandan sonra BU CÜMLƏNİ İŞLƏDİB - YENİ DETAL İnanılmaz çay: Dağların arasından yamaca "qalxır - Bu necə baş verir?

İnanılmaz çay: Dağların arasından yamaca "qalxır - Bu necə baş verir? İdrak Liseyinin binası Ruslan Eyyubovun imiş

İdrak Liseyinin binası Ruslan Eyyubovun imiş Bazar günü bəzi yerlərə intensiv QAR YAĞACAQ

Bazar günü bəzi yerlərə intensiv QAR YAĞACAQ Türkiyədə 15 kənd karantinə alındı

Türkiyədə 15 kənd karantinə alındı "İdrak" liseyində müəllimini güllələyən ŞAGİRD BARƏDƏ QƏRAR

"İdrak" liseyində müəllimini güllələyən ŞAGİRD BARƏDƏ QƏRAR